Embedding Layer

Basic concept for Embedding Layer in NLP.

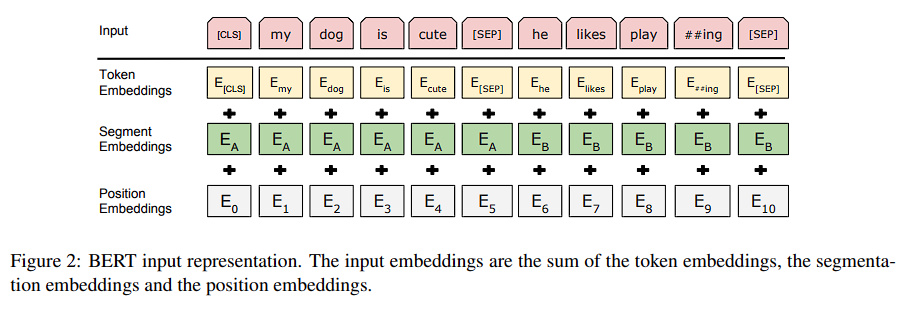

BERT input representation.

Introduction

嵌入層的主要作用是將離散的標識映射到連續的向量空間,以便神經網絡可以有效地處理和學習這些數據的內在結構和關係。

Token Embeddings

最淺層嵌入,只代表詞語的淺層特徵,沒有上下文脈絡。

Segment Embeddings

成對的輸入分對

Position Embeddings

為了補足 Transformer 沒有位置訊息的限制,以 Bert 來說因為同時做平行運算所以無法取得順序訊息。

Absolute Positional Encoding

Relative Positional Encoding

BERT Tags

- CLS: 置於序列之首

- SEP: 置於句子與句子之間,用於分開兩句子